- Home

- Chi siamo

- Chi siamo – il laboratorio

- Iscriviti alla newsletter

- Il Manifesto di Carteinregola

- Le nostre regole

- Rete di Carteinregola

- Le iniziative di Carteinregola dal dicembre 2020

- Tutte le nostre iniziative

- Fatti sentire! Impariamo a usare gli strumenti di comunicazione

- Censimento

- Piediperterra

- Piediperterra a Dragona e Dragoncello

- 1. Parco del Drago: appunti per una introduzione storica

- 2. Dragoncello: storia del Parco del Drago, Convenzione urbanistica PRU e progetti

- 3. Storia di Dragona

- 4. Dragona: il Museo D. Agostinelli

- 5. Dragona: il Punto Verde Qualità

- 6. Dragona: La stazione Acilia sud Dragona

- 7. Dragona – Dragoncello: Dorsale mare Tevere

- 8. Progetto Casale Dragoncello

- Piediperterra a San Lorenzo – Municipio II Roma

- Piediperterra a Testaccio

- Piediperterra a Casal Bertone – 5 luglio 2018

- Piediperterra 1

- Piediperterra 2 a Morena

- Spiazmoli! Piediperterra all’EUR 3- Spiazziamoli! IL PERCORSO

- Piedi per terra al Torrino sud il 20 gennaio 2017

- Piediperterra a Primavalle -28 aprile 2018

- Piediperterra a Dragona e Dragoncello

- Diario Presidio Campidoglio 2012-2013

- Dieci parole dell’ urbanistica

- Rassegna stampa

- Laboratorio

- La Mappa

- Calendario

- Istituzioni

- ISTITUZIONI

- Governo Italiano

- ROMA CAPITALE

- La consiliatura Gualtieri dal 2021

- Deliberazioni dell’Assemblea Capitolina dal 2021

- Deliberazioni della Giunta Gualtieri dal 2021

- Roberto Gualtieri Sindaco

- La Giunta Capitolina 2021

- Silvia Scozzese Vicesindaco e Assessore al Bilancio

- Sabrina Alfonsi, Assessore ai Rifiuti, Ambiente e Agricoltura

- Andrea Catarci Assessore al decentramento, partecipazione e servizi al territorio per la città dei 15 minuti

- Barbara Funari, Assessore alle Politiche Sociali e alla Salute.

- Miguel Gotor, Assessore alla cultura

- Monica Lucarelli Assessore alle Attività produttive e Pari opportunità

- Alessandro Onorato Assessore al Turismo, Grandi Eventi e Sport

- Eugenio Patanè Assessore ai Trasporti

- Claudia Pratelli Assessore alla Scuola, Formazione e Lavoro

- Ornella Segnalini Assessora ai Lavori Pubblici e alle Infrastrutture

- Tobia Zevi Assessore al Patrimonio e Politiche abitative

- Maurizio Veloccia – Assessore all’Urbanistica

- Assemblea Capitolina 2021

- Presidenti, Giunte, Consiglieri Municipi dal 2021

- Roma Capitale e CittàMetropolitana

- Le aziende partecipate del Comune di Roma

- Comune di Roma leggi norme e regolamenti

- La consiliatura Gualtieri dal 2021

- Elezioni a Roma

- Regione Lazio

- ISTITUZIONI

- PoliticaLab

- iDossier

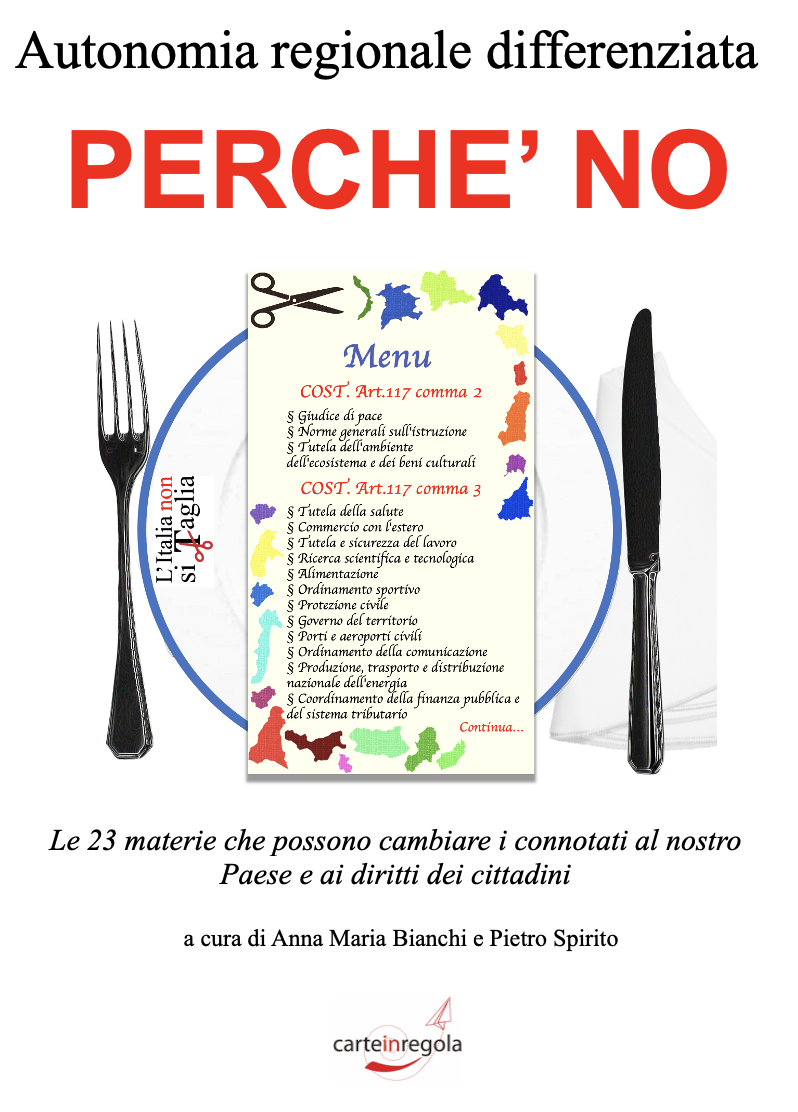

- Autonomia Regionale Differenziata, cronologia e materiali

- Modifiche al PRG di Roma

- PianoCasa/Legge rigenerazione urbana Lazio

- Progetto Porto turistico – crocieristico di Fiumicino – cronologia e materiali

- Affittacamere, case per vacanze, B&B a Roma e nel Lazio – cronologia e materiali

- Lago ex SNIA Viscosa – V Municipio

- Ex clinica Villa Bianca Cronologia

- Stadio Flaminio – II Municipio cronologia

- Circolo Poste e sotto ponte della Musica – cronologia e materiali

- Lago e area ex SNIA Viscosa – V municipio

- Regolamento del Verde di Roma

- PTPR – Piano Territoriale Paesaggistico Regionale (del Lazio)

- PatrimonioComune cronologia materiali

- PUP Piano Urbano Parcheggi cronologia materiali

- ProgettoFlaminio

- DecretoTrasparenza

- V.I.A. Valutazione Impatto Ambientale

- Stadio Tor di valle cronologia

- Pineta di Villa Massimo (Punto Verde Infanzia) II Municipio

- Il Parco di Centocelle – V Municipio – cronologia e materiali

- Pianidizona

- PVQ

- MetroC

- Torri dell’EUR

- ForteTrionfale

- Autorecupero a scopo abitativo del patrimonio pubblico esistente – cronologia e materiali

- ATAC – cronologia e materiali

- BastaCartelloni

- iQuaderni

- Stadio Pietralata

- Modifiche al PRG di Roma

- Regolamento del Verde

- L’Italia non si taglia

- Giubileo 2025

- Referendum NO AD

Widgetized Section

Go to Admin » Appearance » Widgets » and move Gabfire Widget: Social into that MastheadOverlay zone

Valigiablu: Come elaboriamo l’informazione che riceviamo e gli errori della nostra mente

Un’analisi di ValigiaBlu che spiega molto bene come funzioniamo quando selezioniamo informazioni, soprattutto “politiche”

Come elaboriamo l’informazione che riceviamo e gli errori della nostra mente di Valigia Blu

[Tempo di lettura stimato: 10 minuti] di Francesca Amenduni

[Tempo di lettura stimato: 10 minuti] di Francesca Amenduni

Come vengono processate le informazioni che contraddicono ciò in cui crediamo

Che approccio assumiamo di fronte alle nuove notizie? Le percepiamo, elaboriamo e memorizziamo per quelle che sono? La ricerca psicologica dell’ultimo secolo ha iniziato a rispondere a queste domande, fornendoci delle chiavi di lettura per guardare a ciò che accade ogni giorno quando processiamo nuove informazioni e formiamo le nostre deduzioni sulla realtà che ci circonda.

Si pensi a un caso trattato qualche mese fa da Valigia Blu, sulla notizia dell’assalto da parte dei cittadini di Giovinazzo ai Centri di Assistenza Fiscale (CAF) per richiedere i moduli per il reddito di cittadinanza. La notizia pubblicata dalla Gazzetta del Mezzogiorno l’8 marzo è stata condivisa in maniera virale sui social network nel giro di poche ore. Molti hanno colto l’occasione per tracciare e ribadire l’identikit dell’ingenuo elettore medio Cinque Stelle, sbeffeggiato per aver creduto nell’immediata attuazione del reddito di cittadinanza prima ancora che si insediasse il Governo.

Il processo di elaborazione, diffusione e manipolazione di tale notizia, può fornirci un esempio lampante di bias di conferma, la tendenza inconsapevole a ricercare e interpretare evidenze in linea con le proprie ipotesi e aspettative. È ragionevole pensare che, nello specifico caso, la notizia abbia catturato l’attenzione di tutti coloro che avevano un’opinione consolidata sull’elettorato Cinque Stelle, per la quale non si è avvertita l’esigenza di fermarsi e accertarsi che l’informazione fosse corretta. È interessante osservare che gli stessi giornalisti non siano stati immuni da tale effetto, nonostante il ruolo che si presuppone abbiano nel supportare l’elaborazione corretta delle informazioni.

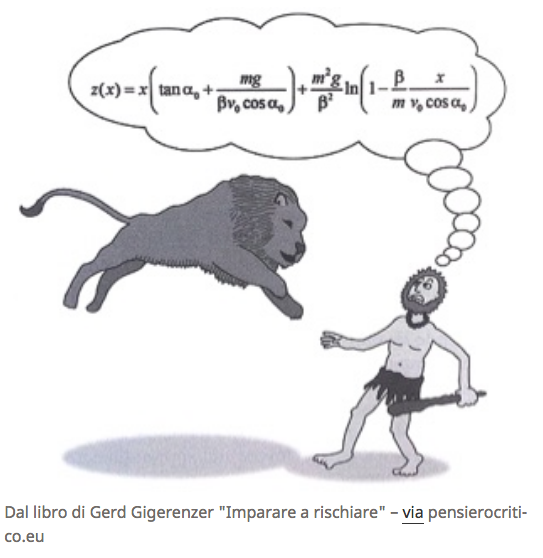

Il caso mediatico del CAF di Giovinazzo è solo un esempio di come le nostre scorciatoie cognitive, definite dalla psicologia euristiche (le regole che gli individui seguono per formulare giudizi in maniera rapida ed efficiente), possano condurci a commettere degli errori e a ritenere credibile per default un’informazione in linea con delle categorie apprese. Le euristiche non sono di per sé negative e, in una prospettiva evoluzionistica, si sono sviluppate per garantire l’adattamento della nostra specie. In ambienti pericolosi, dove il cervello dell’homo sapiens si è evoluto, le decisioni su come reagire di fronte a un pericolo dovevano essere prese in maniera rapida, lasciando poco spazio al ragionamento logico formale e matematico.

Dal libro di Gerd Gigerenzer “Imparare a rischiare” – via pensierocritico.eu

Con le stesse strutture cerebrali di uomini vissuti milioni di anni fa, oggi le scelte da affrontare spesso richiedono uno sforzo di diversa natura e ci sono condizioni in cui, tali scorciatoie possono condurci a commettere errori sistematici, definiti dalla psicologia bias cognitivi. Identificare le scorciatoie che comunemente vengono messe in campo quando si trattano temi complessi e controversi, può renderci più consapevoli e inclini a minimizzare gli errori.

Una mente che tende all’efficienza piuttosto che all’efficacia

Francis Bacon, grande filosofo del XVII secolo, fu uno tra i primi a spiegare che alcuni errori di ragionamento sono connaturati ai processi mentali degli esseri umani. Tra questi Bacon riportò l’esempio “della tendenza universale a notare più prontamente evidenze che provano la nostra credenza piuttosto che quelle che la contraddicono”. Oggi la formulazione del filosofo rimane pressoché invariata, avendo trovato ampio riscontro negli studi sperimentali di numerosi psicologi che coniarono il termine bias di conferma, una specifica tipologia di bias cognitivo.

Come nella maggior parte dei casi, tale errore deriva spesso, ma non esclusivamente, dell’esigenza di ottimizzare l’uso delle energie mentali attraverso delle scorciatoie. Di fronte a un gran numero di informazioni, l’unica opzione è compiere un processo di filtraggio e il cervello umano ha sviluppato dei “trucchi” per selezionare in maniera rapida le informazioni che suppone essere utili. L’euristica del test positivo è un esempio di scorciatoia mentale, che consiste nella tendenza a formulare prove a conferma della propria ipotesi piuttosto che a falsificarla.

[Un video che mostra la nostra naturale tendenza alla verifica]

Questa strategia può indurre a conclusioni errate poiché inferenze differenti possono essere compatibili con gli stessi dati. Un esempio è la diagnosi di una malattia psichiatrica. Un medico formula l’ipotesi di disturbo dell’umore e per testarla pone una serie di domande al paziente: hai provato sensazioni di ansia nelle ultime due settimane? Ci sono state modifiche nel tuo comportamento alimentare? Con queste domande il medico cerca una conferma della sua ipotesi nelle risposte del paziente. Tuttavia, è noto che in psichiatria gli stessi sintomi siano alla base di diversi disturbi e dunque, con il solo il test di conferma, il medico rischierebbe di accettare la sua prima ipotesi, escludendo tutte le altre possibilità. In uno studio condotto con studenti di medicina e fisiologia, Barrows e colleghi osservarono che una volta formulata una ipotesi, questa influenzava negativamente il processo di acquisizione delle informazioni poiché gli studenti tendevano a cercare solo prove a supporto della loro ipotesi.

Sempre nell’ambito medico, il bias di conferma entra in gioco anche nella valutazione dell’efficacia delle terapie. Nickerson spiega che, nella storia della medicina, la valutazione di efficacia dei trattamenti terapeutici è stata a lungo influenzata dai soli casi di guarigione, ignorando invece le situazioni in cui il trattamento non portava a dei benefici o la guarigione avveniva spontaneamente.

In maniera simile, oggi i promotori delle medicine alternative possono vantare un gran numero di pazienti pronti a testimoniare in totale sincerità di aver beneficiato dei loro trattamenti. Il successo di tali terapie si basa su un meccanismo psicologico molto semplice: quando le persone mettono in campo un’azione, come assumere un farmaco omeopatico, lo fanno perché suppongo vi sia una relaziona causale tra farmaco e risultato sulla salute. Se ottengono i benefici previsti, la tendenza è considerarla come una prova della relazione di causa-effetto ipotizzata. Al contrario, riflettere sulla possibilità che la guarigione sarebbe avvenuta anche senza farmaco, richiederebbe lo sforzo cognitivo di valutare ipotesi alternative. Nickerson afferma che in tutti i casi in cui la mente predilige la via più efficiente e non la più efficace, la tendenza naturale è prendere in considerazione solo una ipotesi alla volta, valutare che l’ipotesi sia o vera o falsa, ma non considerare simultaneamente entrambe le possibilità.

Il desiderio di credere

In molti casi il bias di conferma non è la conseguenza di un processo di ottimizzazione delle risorse cognitive, ma è fortemente radicato nelle nostre emozioni e motivazioni. Sara Gorman e Jack Gorman, tramite l’impiego di risonanza magnetica, hanno osservato che quando alle persone vengono presentate informazioni a supporto delle loro credenze, nel cervello si attivano i circuiti legati alla produzione di dopamina, neurotrasmettitore coinvolto nei processi motivazionali e di rinforzo. In questi casi, si preferisce parlare di bias di desiderabilità o myside bias operando la seguente distinzione: il bias di conferma è la tendenza a preferire informazioni che confermano le nostre credenze e a evitare le informazioni che le contraddicono. Il bias di desiderabilità, invece, è la tendenza a ritenere più attendibili quelle informazioni in cui noi desideriamo credere.

In uno studio del 2017, i ricercatori Ben Tappin, Leslie Van Der Leer e Ryan Mckay si sono chiesti se la riluttanza a modificare le credenze politiche fosse dovuta al bias di conferma o a quello di desiderabilità. I ricercatori chiesero a un campione di 900 elettori statunitensi quale candidato avrebbero voluto che vincesse e quale secondo loro aveva maggiori probabilità di vincere. I rispondenti furono classificati in due gruppi: nel primo c’erano coloro che credevano che il loro candidato preferito avrebbe vinto (ad esempio, i supporter di Clinton che credevano che lei avrebbe vinto) mentre nel secondo chi credeva che il proprio candidato preferito avrebbe perso (ad esempio, i supporter di Trump che credevano che avrebbe vinto Hilary Clinton). A metà dei partecipanti venivano mostrati i risultati di sondaggi fittizi sulla probabile vittoria di Trump e all’altra metà sulla vittoria di Clinton. Dopo aver visionato i sondaggi, ai partecipanti veniva chiesto nuovamente di indicare quale candidato aveva maggiori probabilità di vincere: solo chi ricevette sondaggi che sottolineavano la probabile vittoria del proprio candidato preferito era incline a modificare la valutazione iniziale sulla probabilità di vittoria del candidato. Al contrario, le persone che lessero i sondaggi a favore del candidato avversario, non incorporavano le nuove evidenze e riproponevano le stesse risposte date prima di visualizzare i sondaggi. Nel contesto di questo studio, il comportamento dei partecipanti può essere meglio spiegato dal bias di desiderabilità più che dal bias di conferma, poiché solo chi leggeva evidenze gradite era disposto a modificare la propria opinione iniziale e tale effetto è stato riscontrato nella stessa misura per i supporter di Trump e di Clinton.

Per spiegare ciò che accade quando le persone si trovano a dover mettere in discussione una certa idea, come la probabilità di vittoria di un candidato, è stato sviluppato un modello basato su studi neuro scientifici: gli autori affermano che ogni oggetto nella nostra mente sia connesso a uno stato affettivo. Quando le persone sono esposte a un oggetto, lo stato affettivo si attiva in maniera molto rapida e inconsapevole, influenzando i processi di natura cognitiva quali la codifica delle nuove informazioni, la selezione dei ricordi dalla memoria a lungo termine e il processo di comprensione. Nei casi in cui nuove informazioni attivino emozioni di natura negativa, le persone tenderebbero a razionalizzarle.

Per spiegare cosa si intende per razionalizzazione, nella sua netta distinzione dal pensiero razionale, consideriamo l’esperimento di Jones e Kohler sulle posizioni dei cittadini degli Stati Uniti in merito alla segregazione razziale. I ricercatori selezionarono degli individui che avevano una posizione netta sulla questione, sia a favore sia contro la segregazione. Ai partecipanti vennero presentati dei saggi a favore di entrambe le posizioni, metà dei quali ragionevoli e metà evidentemente infondati. Se avessero ragionato in maniera razionale, i soggetti avrebbero analizzato con attenzione le argomentazioni ragionevoli, sia a favore che contro la propria idea. Tuttavia, emerse in maniera lampante che i partecipanti ricordavano meglio solo gli argomenti ragionevoli a favore della loro posizione e in più gli argomenti poco plausibili a supporto della parte avversa. Ciò avveniva probabilmente perché leggere argomentazioni assurde a favore della propria posizione generava la sensazione spiacevole che questa fosse fondata su argomenti poco solidi. Allo stesso modo leggere argomentazioni plausibili a favore della posizione opposta implicava la possibilità di considerare l’opzione contraria alla propria più ragionevole di quanto non si volesse pensare.

La razionalizzazione è anche alla base del ragionamento motivato, la tendenza a trovare spiegazioni a favore della propria ipotesi, quando ci si trova di fronte a evidenze che la mettono in discussione. La presenza di due informazioni incoerenti (ciò in cui credo ed evidenze contrarie) generano una sensazione spiacevole nota come dissonanza cognitiva. È proprio qui che entra in gioco il ragionamento motivato, per ridurre la dissonanza e le sensazioni spiacevoli a essa legata.

Si pensi al caso di una campagna di sensibilizzazione sui vaccini. In uno studio del 2013, i ricercatori osservarono che la loro campagna era riuscita a ridurre in maniera efficace l’idea di una relazione causale tra vaccini ed autismo. Tuttavia, si osservarono dati apparentemente contraddittori: le persone che prima della campagna erano contrarie alla vaccinazione continuavano a percepire i rischi degli effetti collaterali dei vaccini e la loro convinzione di non vaccinare i propri figli ne risultò rinforzata.

Com’è possibile che pur eliminando la principale causa di preoccupazione legata alla vaccinazione, l’idea di non vaccinare i figli fosse diventata ancora più solida? L’effetto per cui di fronte a una evidenza che confuta la nostra idea, la convinzione che possediamo invece che indebolirsi si rinforza, è noto come Backfire effect. È plausibile che i partecipanti che prima della campagna pro-vaccini erano contrari alla vaccinazione dei figli, abbiano valutato nella loro mente una serie di motivazioni alternative per difendere la loro idea di partenza e che questo processo abbia spinto loro ad essere ancora più contrari alla vaccinazione. I ricercatori evidenziano, in conclusione, l’importanza di adottare narrative più sottili e meno esplicite per ridurre il rischio che le risorse cognitive vengano impiegate per preservare e difendere le proprie posizioni, invece che per assimilare nuove evidenze.

Algoritmi che confermano

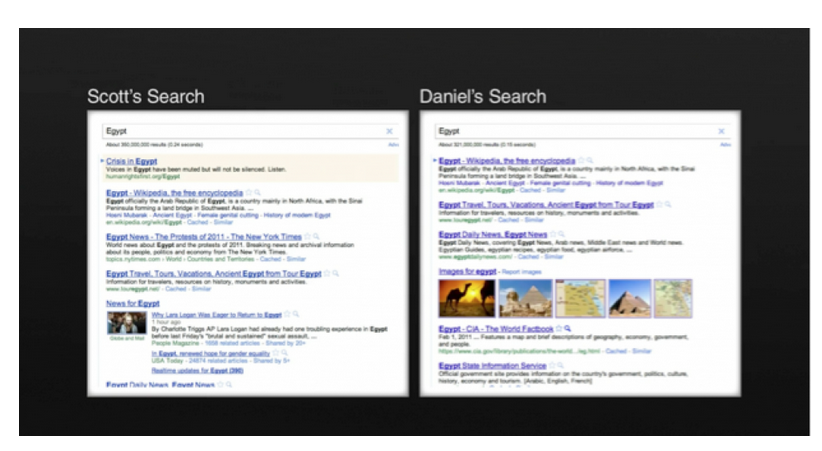

Rispetto a quanto detto, la vastità, varietà e accessibilità delle informazioni nell’era di Internet potrebbe porci frequentemente nella condizione spiacevole di essere contraddetti. Questo è stato probabilmente vero fino al 4 dicembre del 2009 quando il blog di Google pubblicò un post dal titolo “Personalized search for everyone” (“Risultati di ricerca personalizzati per tutti”). Sebbene il post non ottenne una grande attenzione mediatica nell’immediato, si trattava di un momento di svolta decisivo: da quel giorno in poi l’algoritmo di Google avrebbe smesso di fornire i risultati più autorevoli, per restituire ad ogni utente una dieta informativa personalizzata su misura.

Per capire concretamente di che si tratta, prendiamo l’esempio dei risultati di una ricerca svolta da Scott e Daniel nel 2012. Entrambi scrissero sulla barra di ricerca Google la parola “Egypt”: mentre a Scott veniva restituita tra i risultati principali la notizia più importante di quei giorni sulle proteste in Egitto, per Daniel ciò non è avvenuto.

Eli Pariser utilizzò questo esempio per spiegare ciò che nel suo celebre libro definì “filter-bubble” o “gabbia dei filtri”: La nuova generazione dei filtri di internet guarda tutto ciò che sembra piacerti – le cose che hai realmente fatto o le cose che piacciono alle persone che ti piacciono – e cerca di estrapolarle. Questi sono strumenti di predizione, che costantemente creano e rifiniscono una teoria di chi sei tu e di cosa farai o vorrai fare dopo. Insieme questi strumenti creano un unico universo di informazioni per ciascuno di noi che io ho chiamato Filter Bubble” – ciò che fondamentalmente modificherà il processo in cui noi incontriamo idee e informazioni.

L’aspetto più preoccupante secondo l’autore è che si rischia di perdere consapevolezza di ciò che rimane al di fuori dall’universo informativo, come nel caso di Daniel e delle proteste in Egitto. In questo modo, la gabbia dei filtri riduce drasticamente le occasioni di provare dissonanza cognitiva, diminuendo l’esposizione a informazioni che contraddicono le proprie idee.

Sono ancora scarsi i risultati empirici sugli effetti a lungo termine della personalizzazione della dieta informativa ad opera di algoritmi, probabilmente a causa di un’attenzione relativamente recente nei confronti del fenomeno. Secondo un articolo del 2016, l’effetto della filter bubble su conoscenze e atteggiamenti politici, seppur significativamente presente avrebbe un impatto molto piccolo. Un effetto non decisivo è probabilmente dovuto al paesaggio mediatico fortemente frammentato e alla possibilità per ciascuno di accedere a un’abbondanza di informazioni attraverso diverse fonti. Inoltre, le persone possono essere sottoposte a informazioni contraddittorie anche attraverso le conversazioni con colleghi, amici e familiari. Gli autori concludono dunque che, a discapito delle forti preoccupazioni, ad oggi non vi sono evidenze empiriche che le giustifichino.

Come ha scritto Rasmus Kleis Nielsen, Director of Research del Reuters Institute for the Study of Journalism presso l’Università di Oxford, il dibattito sull’informazione è in larga misura influenzato dai cosiddetti ‘negazionisti del cambiamento mediatico’, persone che promuovono convinzioni fallaci in netta contraddizione con le evidenze frutto della ricerca scientifica sull’argomento.

Nielsen fa l’esempio della convinzione (erronea) che chi si informa utilizzando i social network è maggiormente esposto alle bolle di filtraggio e, di conseguenza, a notizie che confermano il proprio punto di vista. I ricercatori hanno provato a verificare questa convinzione e un crescente numero di studi indipendenti ha scoperto che è vero l’esatto contrario: i motori di ricerca e i social media portano le persone ad avere una dieta informativa più variata (qui, qui e qui alcuni esempi).

Il dibattito sul tema sembra essere necessario perché la personalizzazione è ancora in una fase primordiale e il rischio verso cui si va incontro è che alcuni utenti vengano sempre meno esposti ad argomenti importanti per la società nel suo complesso, causando una sempre maggiore polarizzazione nelle opinioni e nelle posizioni.

È possibile controllare l’effetto dei bias?

Se pensi che tutto ciò riguardi qualcun altro e non te, o se leggendo questo articolo hai pensato che gli altri siano maggiormente inclini alle scorciatoie cognitive, sei probabilmente vittima di un altro bias, il così detto bias blind spot, la tendenza a sottostimare l’impatto degli errori sistematici sulle tue scelte ma a riconoscerne l’influenza sulle altre persone.

Questa spiacevole notizia può, tuttavia, essere controbilanciata dalla consapevolezza che la predisposizione ai bias non è correlata ai fattori cognitivi, come l’intelligenza. Dunque, sebbene sia impossibile essere immuni a tali effetti, la consapevolezza di questi errori può aiutare tutti a diventare più resistenti alla loro influenza.

Per essere meno inclini agli errori sistematici non è sufficiente allenare la logica formale, le abilità matematiche e il calcolo delle probabilità, sebbene questi siano aspetti cruciali del ragionamento scientifico, avverso all’euristica del test positivo. È tuttavia altrettanto importante modulare le emozioni che proviamo quando veniamo contraddetti, sentirci incuriositi piuttosto che vergognarci quando scopriamo di esserci sbagliati, chiedere invece di attaccare quando ci vengono riportate evidenze che mettono in discussione la nostra posizione. Qual è la nostra priorità, difendere le nostre idee o guardare al mondo il più possibile per quello che è davvero? Immagine in anteprima via pixabay.com

Ricorda di citare la fonte: https://www.valigiablu.it/notizie-cervello-pregiudizi/

Licenza cc-by-nc-nd valigiablu.it

Subscribe

Login

0 Commenti